¿Qué es una sucesión?

Una sucesión es una serie ordenada de elementos, generalmente números, que siguen un patrón o una regla. Cada elemento de la sucesión se denomina término y se identifica por su posición en la serie. La sucesión se representa de la siguiente manera: {a₁, a₂, a₃, …}.

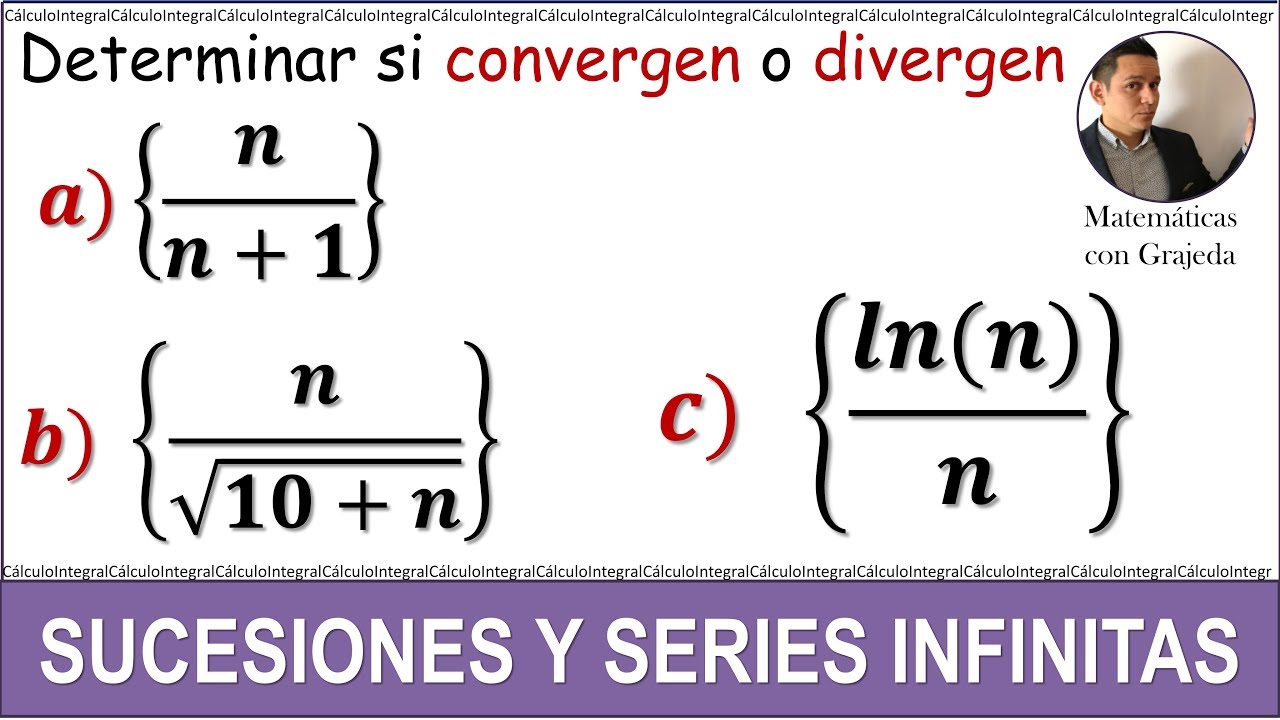

Convergencia de una sucesión

Cuando hablamos de la convergencia de una sucesión, nos referimos a la situación en la que los términos de la serie se acercan cada vez más a un valor límite a medida que la posición de los términos aumenta hacia el infinito. Este valor límite se conoce como el límite de la sucesión.

Para determinar si una sucesión converge, debemos evaluar la tendencia de los términos a medida que avanzamos en la serie. Existen diferentes métodos para determinar la convergencia de una sucesión, entre ellos, el teorema del límite y el criterio de Cauchy.

Teorema del límite

El teorema del límite establece que si el límite de una sucesión existe y es igual a un valor finito, entonces la sucesión es convergente. Esto significa que los términos de la sucesión se acercan cada vez más a ese valor límite a medida que avanzamos en la serie.

Por ejemplo, consideremos la sucesión {1/n}. A medida que aumentamos la posición de los términos, es decir, cuando n se acerca a infinito, los valores de la sucesión se acercan cada vez más a cero. Por lo tanto, podemos concluir que esta sucesión converge hacia cero.

Criterio de Cauchy

El criterio de Cauchy establece que una sucesión converge si para cualquier número positivo ε, existe un número natural N tal que para todos los términos de la sucesión a partir de la posición N, la diferencia absoluta entre los términos es menor que ε.

En otras palabras, si podemos encontrar un punto en la sucesión a partir del cual los términos están lo suficientemente cerca entre sí, entonces la sucesión converge. Este criterio se basa en la idea de que una sucesión convergente se hace cada vez más «apretada» a medida que avanza hacia el infinito.

Divergencia de una sucesión

En contraste con la convergencia, la divergencia de una sucesión ocurre cuando los términos de la serie no se acercan a ningún valor límite a medida que avanzamos en la serie. En términos más simples, los términos de la sucesión pueden alejarse cada vez más de un valor determinado o pueden oscilar entre diferentes valores sin converger hacia ninguno de ellos.

Existen diferentes formas en las que una sucesión puede divergir. Puede ser que los términos se alejen hacia infinito positivo o negativo, o que la sucesión sea divergente oscilante, es decir, que los términos oscilen entre diferentes valores sin converger hacia ninguno de ellos.

En resumen, cuando una sucesión converge, los términos se acercan cada vez más a un valor límite a medida que avanza hacia el infinito, mientras que cuando una sucesión diverge, los términos no se acercan a ningún valor límite o pueden alejarse hacia infinito ooscilar entre diferentes valores. La convergencia y la divergencia son conceptos fundamentales en el estudio de sucesiones y tienen aplicaciones en diversos campos como el análisis matemático y la física.

¿Puede una sucesión converger y diverger al mismo tiempo?

No, una sucesión no puede converger y diverger al mismo tiempo. La convergencia y la divergencia son conceptos mutuamente excluyentes. Una sucesión puede ser convergente o divergente, pero no ambas cosas simultáneamente.

¿Cómo puedo determinar si una sucesión converge o diverge?

Existen diferentes métodos para determinar la convergencia o divergencia de una sucesión, como el teorema del límite y el criterio de Cauchy. Estos métodos requieren evaluar la tendencia de los términos de la sucesión a medida que avanzamos en la serie.

¿Qué aplicaciones tiene el estudio de la convergencia y la divergencia de sucesiones?

El estudio de la convergencia y la divergencia de sucesiones tiene aplicaciones en áreas como el análisis matemático, la física y la teoría de la probabilidad. Estos conceptos son fundamentales para comprender el comportamiento de las series infinitas y para el análisis de fenómenos que involucran secuencias numéricas.