El cálculo integral es una rama fundamental de las matemáticas que nos permite encontrar las áreas bajo las curvas y resolver problemas relacionados con el cambio en variables a lo largo de un intervalo dado. Una de las técnicas más utilizadas en el cálculo integral es el criterio de la raíz, que nos ayuda a determinar si una serie converge o diverge. En este artículo, te guiaremos paso a paso a través del uso del criterio de la raíz en el cálculo integral, especialmente dirigido a aquellos que están comenzando su viaje en el mundo de las matemáticas.

¿Qué es el criterio de la raíz y cómo se aplica en las series?

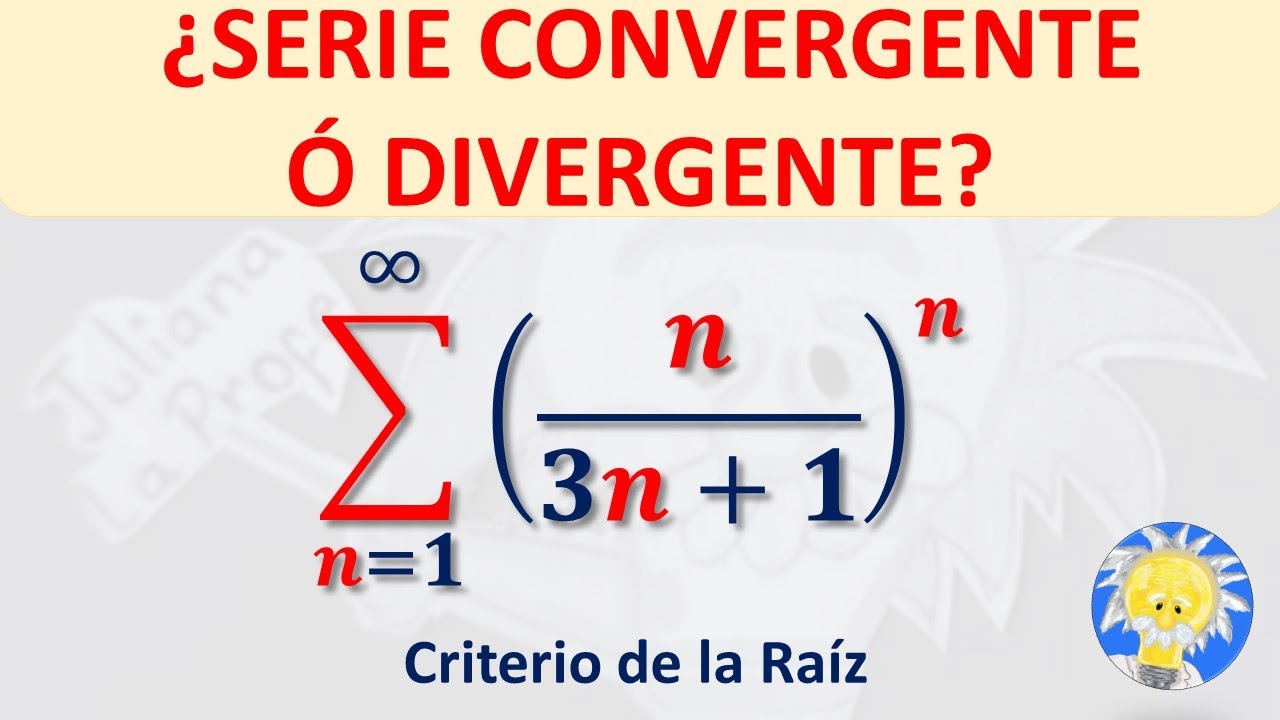

El criterio de la raíz es una estrategia utilizada para analizar la convergencia o divergencia de una serie infinita. Para aplicar el criterio de la raíz, debemos calcular la raíz n-ésima de los términos de la serie y observar el límite de esta raíz cuando n tiende al infinito.

Si el límite de la raíz n-ésima es menor que 1, podemos afirmar que la serie converge. Por otro lado, si el límite es mayor que 1, la serie diverge. En caso de que el límite sea igual a 1, el criterio no nos proporciona información concluyente y debemos utilizar otros métodos para determinar la convergencia o divergencia de la serie.

Paso 1: Identificar la serie

El primer paso para aplicar el criterio de la raíz es identificar la serie que deseamos analizar. Una serie está compuesta por una sucesión de términos sumados, y se denota como:

S = a₁ + a₂ + a₃ + … + aₙ + …

Donde a₁, a₂, a₃, … son los términos de la serie.

Paso 2: Aplicar el criterio de la raíz

Una vez que hemos identificado la serie, debemos calcular la raíz n-ésima de los términos de la serie. Esto se hace elevando cada término a la potencia 1/n. Es decir, para cada término aₙ, calculamos:

∛aₙ = aₙ^(1/n)

Paso 3: Calcular el límite de la raíz n-ésima

Una vez que hemos obtenido la raíz n-ésima de cada término de la serie, es necesario calcular el límite de esta raíz cuando n se acerca al infinito. Esto se representa matemáticamente como:

limₙ→∞ ∛aₙ

Si el límite obtenido es menor que 1, podemos concluir que la serie converge. Por ejemplo, si el límite es 0.5, esto significa que la serie tiende a acercarse a cero a medida que n crece, lo cual indica convergencia.

Por otro lado, si el límite es mayor que 1, la serie diverge. Por ejemplo, si el límite es 2, esto significa que la serie tiende a alejarse hacia el infinito a medida que n crece, indicando divergencia.

1. ¿El criterio de la raíz siempre proporciona una respuesta concluyente sobre la convergencia o divergencia de una serie?

No, en algunos casos el límite de la raíz n-ésima puede ser igual a 1, lo cual no nos brinda información concluyente. En estos casos, es necesario utilizar otros métodos para determinar la convergencia o divergencia de la serie.

2. ¿Cuáles son los otros métodos utilizados para analizar la convergencia o divergencia de una serie?

Existen varios métodos, como el criterio del cociente, el criterio de la integral y el criterio de la comparación, entre otros. Cada uno de estos métodos utiliza diferentes enfoques para determinar la convergencia o divergencia de una serie.

3. ¿El criterio de la raíz se aplica únicamente a series infinitas?

Sí, el criterio de la raíz se utiliza específicamente para analizar la convergencia o divergencia de series infinitas. No puede aplicarse a series finitas.

En resumen, el criterio de la raíz es una herramienta útil en el cálculo integral para determinar si una serie converge o diverge. Siguiendo estos pasos y aplicando el criterio de la raíz, podemos obtener conclusiones sobre la convergencia o divergencia de una serie. Recuerda que este criterio no siempre proporciona respuestas concretas, por lo que es importante considerar otros métodos en caso de obtener un resultado ambiguo. Si tienes alguna pregunta o inquietud, no dudes en consultar nuestras preguntas frecuentes para obtener más información.