Si eres un analista de datos o trabajas en el campo de la estadística, es probable que hayas escuchado sobre las pruebas de bondad de ajuste y las pruebas no paramétricas. Estas son herramientas fundamentales para analizar datos y obtener conclusiones significativas sin hacer supuestos sobre la distribución subyacente de los datos. En esta guía completa, te proporcionaremos una visión detallada de estas pruebas y cómo aplicarlas en tus análisis.

¿Qué son las pruebas de bondad de ajuste?

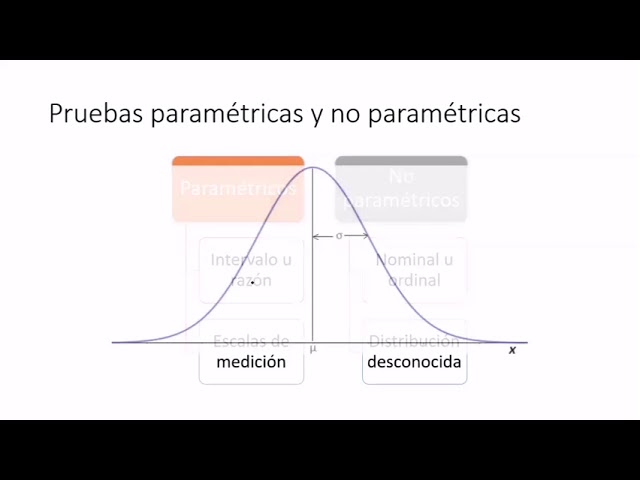

Las pruebas de bondad de ajuste son un conjunto de técnicas estadísticas utilizadas para determinar si una muestra de datos se ajusta a una distribución de probabilidad específica. En otras palabras, estas pruebas ayudan a determinar si los datos provienen o no de una población con una distribución conocida. Esto es especialmente útil cuando se trabaja con datos que podrían no seguir una distribución normal o cuando se desconoce la distribución subyacente.

Las pruebas de bondad de ajuste comunes incluyen la prueba de Kolmogorov-Smirnov, la prueba de chi-cuadrado y la prueba de Anderson-Darling. Cada una de estas pruebas tiene sus pros y sus contras, por lo que es importante comprender las diferencias y elegir la prueba adecuada para el análisis específico que estás realizando.

Pruebas no paramétricas: una alternativa flexible

A diferencia de las pruebas de bondad de ajuste, las pruebas no paramétricas son una alternativa flexible que no requiere hacer supuestos sobre la distribución de los datos. Estas pruebas se basan en la mediana y el rango intercuartil de los datos, en lugar de utilizar el promedio y la desviación estándar.

Las pruebas no paramétricas son particularmente útiles cuando se trabaja con datos categóricos, ordinales o cuando los datos son muy asimétricos. Algunas de las pruebas no paramétricas más comunes son la prueba de Mann-Whitney U, la prueba de Wilcoxon y la prueba de Kruskal-Wallis.

Pruebas de bondad de ajuste: análisis más detallado

Prueba de Kolmogorov-Smirnov

La prueba de Kolmogorov-Smirnov es ampliamente utilizada para determinar si una muestra de datos se ajusta a una distribución específica. Esta prueba compara la función de distribución acumulativa empírica (ECDF) de la muestra con la función de distribución acumulativa teórica esperada.

El resultado de la prueba de Kolmogorov-Smirnov es el valor D, que es la distancia máxima entre la ECDF de la muestra y la función de distribución acumulativa teórica esperada. Si el valor D es pequeño y el valor p asociado es alto, se acepta la hipótesis nula de que los datos se ajustan a la distribución específica. Por el contrario, si el valor D es grande y el valor p es bajo, se rechaza la hipótesis nula y se concluye que los datos no se ajustan a la distribución específica.